ErgoLAB Emotion面部表情分析模塊,是一款專業的面部表情分析與狀態識別工具。系統結合機器學習算法與圖像識別技術,利用面部肌肉特征點計算和分類表情狀態,自動編碼多種基本表情、精確計算情感效價,系統可實時檢測被試的頭部位置、面部特征點、視線朝向、基本生物信息等,結合AI狀態識別進一步實現對操作人員的分心、疲勞、應激等狀態的自動識別以及特定環境條件下的預警反饋。

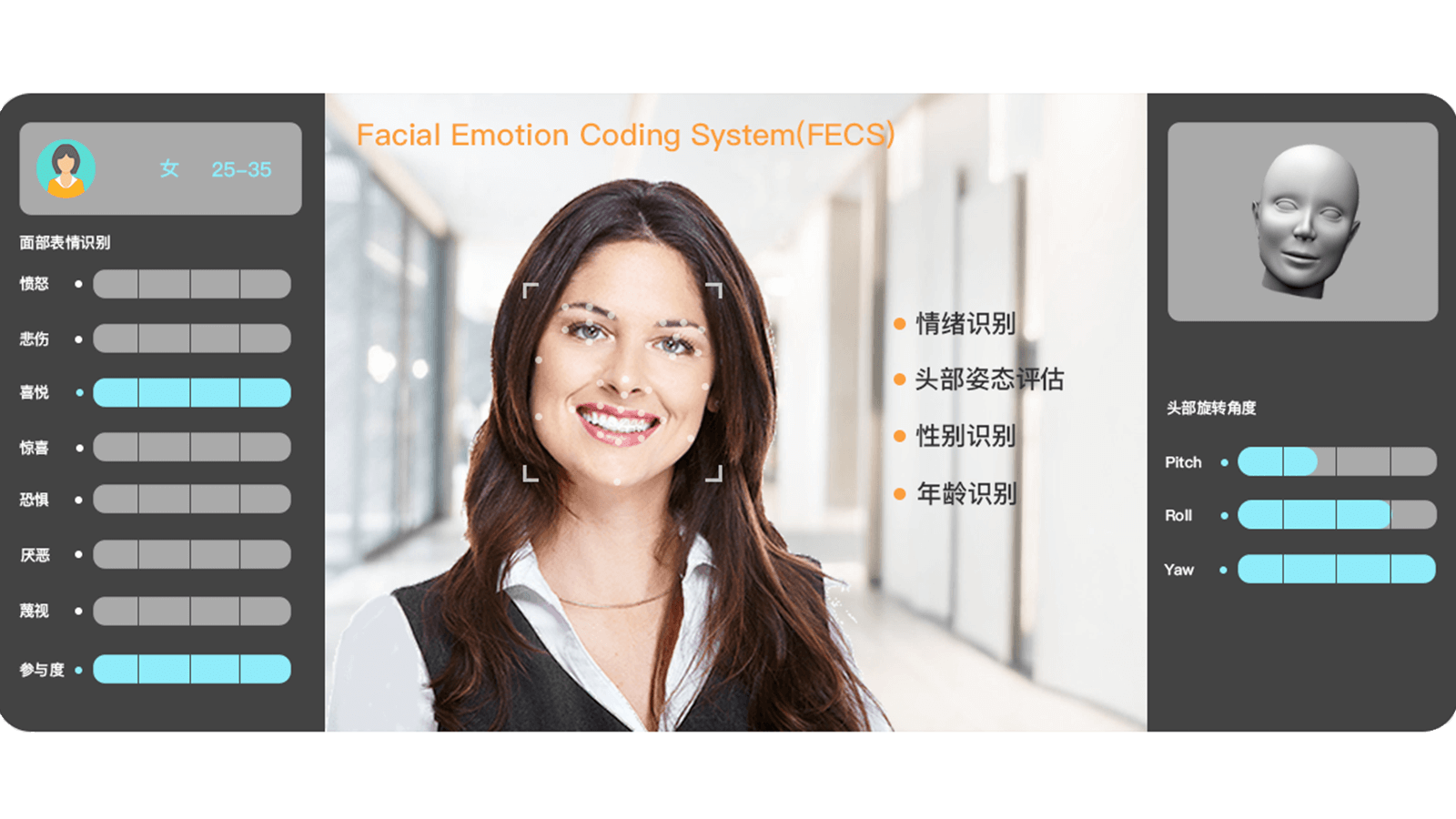

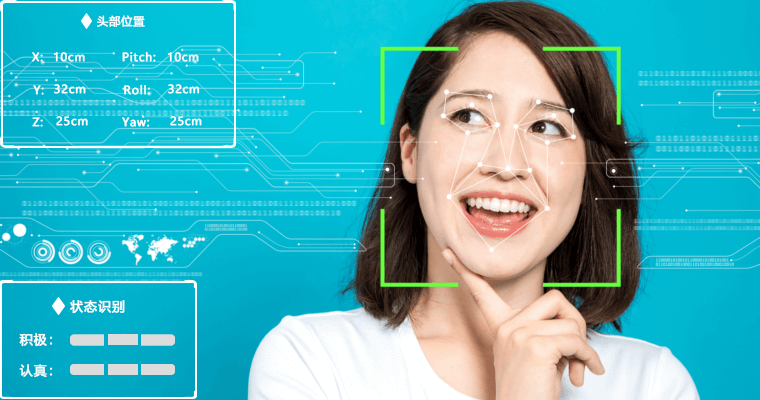

實時自動編碼7種面部表情狀態,包括高興、悲傷、厭惡、恐懼、驚訝、生氣、參與度。實時監測頭部位置坐標Head Position,包括翻滾角Roll、偏航角Yaw、俯仰角Pitch。實時計算面部表情程度值,每種以0至100%區間計算,以及整體面部肌肉的參與度狀態。精確識別個體情感效價,包括正性、中性、負性3種情感狀態及21種微表情數據。自動計算個體的瞳孔距離,識別眼睛注視方向,監測注意狀態。實時計算并識別多個年齡段狀態,以及個體屬性信息,如性別、是否佩戴眼鏡。面部表情自動編碼

面部表情自定義處理參數模塊,包括實時處理及離線處理,如數據插值、中值濾波、均值濾波等,支持自定義程度閾值、合并閾值、以及大腦加工時間。自動識別并編碼七種基本表情,包括高興、悲傷、厭惡、恐懼、驚訝、生氣、參與度,以0至100%區間計算表情程度值。計算多種微表情數據,如抬起眉毛內角、抬起眉毛外角、皺眉(降低眉毛)、上眼瞼上升、臉頰提升、眼輪匝肌外圈收緊/內圈收緊、皺鼻、拉動上嘴唇向上運動、拉動人中部位的皮膚向上、拉動嘴角傾斜向上、急劇的嘴唇拉動、收緊嘴角、拉動嘴角向下傾斜、拉動下唇向下、推動下唇向上、撅嘴、嘴角拉伸、收緊雙唇向外翻、眼睛擴大、張嘴等。狀態識別與預警反饋

系統內嵌情感效價計算模型,精確識別積極、中性、消極情感,客觀評價個體情緒狀態,與多模態數據形成客觀有效的印證關系;系統能夠自動檢測實時跟蹤操作人員頭部朝向,包括俯仰角、偏航角、翻滾角,并測定注視方向,計算瞳孔間距以及注意狀態檢測;結合人工智能與機器學習算法,進一步實現對操作人員的分心、疲勞、應激等狀態的自動識別以及特定環境條件下的預警反饋。面部表情分析與統計

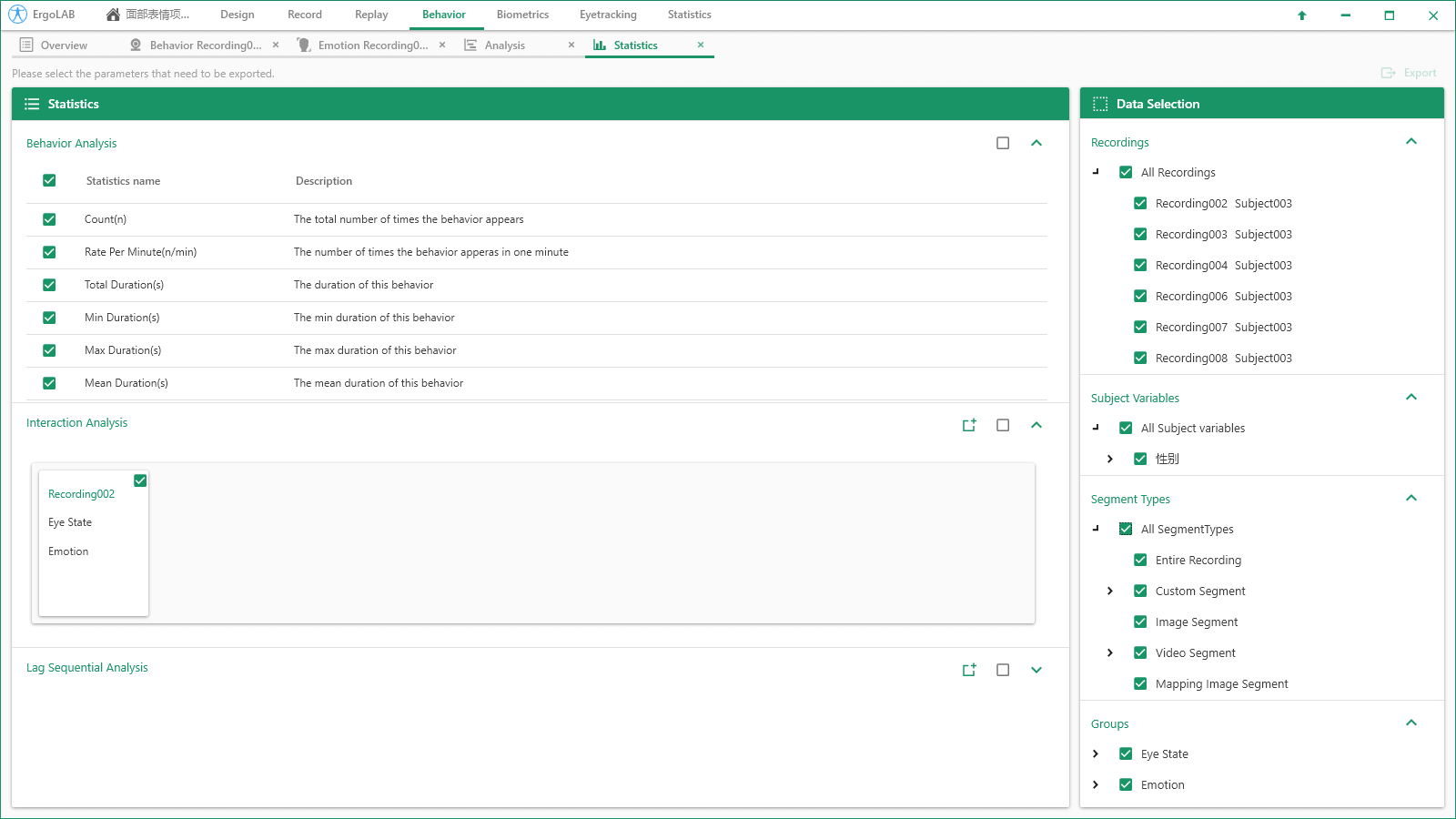

實時可視化的表情編碼:系統實時計算操作人員的表情狀態與情緒效價,在實驗過程中,主試可實時查看與監測操作人員的表情程度與情緒變化,并做出相應的任務調整與行為預警。自動統計面部表情數據:包括每種面部表情的開始時間、結束時間、第一次發生的時間、總發生次數、頻率、每次發生的時間、總的持續時間、總的持續時間在全部觀察時間中所占的百分比、最短的持續時間、最長的持續時間、平均持續時間、持續時間的標準差、持續時間間隔置信區間等數據。多維度數據統計與二次開發

多維度數據交叉統計:系統支持面部表情數據與其他多模態數據(眼動、腦電、生理、動補、行為等)的同步交叉分析,多個數據源在同一平臺界面呈現,在采集的同時間軸數據里選擇相應的時間片段,可同步觀察和統計分析所有數據流之間的相關關系。具有API開發接口:面部表情原始數據與狀態分析結果可以被其他程序實時訪問,可使其它程序對被試者的情緒進行反饋。ErgoLAB人機環境同步云平臺可人-機-環境多維度數據的同步采集與綜合分析,包括眼動追蹤、生理測量、生物力學、腦電、腦成像、行為、人機交互、動作姿態、面部表情、主觀評 價、時空行為、模擬器、物理環境等,為科學研究及應用提供完整的數據指標。平臺可完成完整的實驗和測評流程,包括項目管理-試驗設計-同步采集-信號處理-數據分析-人工智能應用-可視化報告,支持基于云架構技術的團體測試和大數據云管理。